Diese Projektarbeit entstand 2006 an der LMU München, dreht sich aber um ein Projekt, das ich 2005 im Rahmen der Vorlesung „Game Development“ an der National University of Singapore (NUS) umgesetzt habe.

101dalmartians.pdf (~1MB)

Diese Projektarbeit entstand 2006 an der LMU München, dreht sich aber um ein Projekt, das ich 2005 im Rahmen der Vorlesung „Game Development“ an der National University of Singapore (NUS) umgesetzt habe.

101dalmartians.pdf (~1MB)

Zweiseitiger Artikel im Anime-Magazin „Koneko“ (Ausgabe #7)

„Selbsthilfe“ – so könnte man das Phänomen Fansub am besten charakterisieren. Jeder Fan kennt das Problem: in Japan laufen alle paar Monate Dutzende an neuen Anime-Serien an, und hier kommt nur ein Bruchteil dessen an. Und gut genug Japanisch kann man auch nicht, um sich die Serien im Original anzuschauen…

Fansubs setzten es sich zum Ziel, dem Anime-Mangel Abhilfe zu schaffen: man nimmt Videoaufnahmen aus dem japanischen Fernsehen, übersetzt sie, fügt die Übersetzungen als Untertitel ein und lässt Kopien davon anderen Anime-Fans zukommen, die nicht Japanisch können oder sonst keine Bezugsquellen haben. Das ganze geschieht illegal.

Fansubs sind im Wesentlichen eine amerikanische Erscheinung. Seit Mitte der 70er-Jahre war es dank den aufkommenden VHS-Videokassetten möglich, Sendungen im japanischen Fernsehen aufzuzeichnen und in die USA zu schicken. Japanische Videokassetten lassen ich dort, anders als hier in Europa, ohne größere Probleme abspielen. Das führte bald zu Anime-Vorführungen in diversen Anime-Clubs in amerikanischen Universitäten. Anfangs sah das so aus, dass die Animes im japanischen Original gezeigt wurden, und ein des Japanischen mächtiger Fan vor oder während des Films erklärte, um was es gerade ging. Ein erster Anfang also, aber echte Freude kommt da noch nicht auf.

Richtige Fansubs entstanden etwa ein Jahrzehnt später, als die Videotechnik fortgeschritten genug und vor allem günstig genug war. Mit spezieller Technik war es seitdem möglich, dass auch Privatpersonen Untertitel in einen Film hineinmontieren. Das führte zum ersten großen Fansub-Boom: einige wenige Fansubber kauften in Japan Animes auf LaserDisc (der Vorgänger der DVD), übersetzten sie, und erstellten auf recht mühevolle Weise Fansubs, die sie dann „Distributoren“ zukommen ließen. Interessierte Fans konnten dann per Post leere Videokassetten u. Rückporto an die Distributoren schicken, diese kopierten die Fansubs dann auf die Kassette und schickten sie zurück. Das war freilich immer noch verhältnismäßig aufwändig. Trotzdem führte das zu einer schnell wachsenden Fanszene, da viele erst durch Fansubs von Freunden überhaupt darauf aufmerksam wurden, dass es soetwas wie Animes überhaupt gibt.

Zu einem Teil waren die frühen Fansubs also Wegbereitereiter der kommerziellen und massentauglichen Verbreitung von Animes in Amerika. Denn die ersten Video-Anbieter hätten es deutlich schwieriger gehabt zu überleben, hätte es nicht von Anfang an eine recht aktive Fanszene gegeben. Aus diesem Grund waren die Video-Produzenten auch lange Zeit sehr tolerant gegenüber den nichtsdestoweniger illegalen Fansubs.

Die heutige Fansub-Szene hat kaum noch etwas mit der eben Beschriebenen zu tun; „Schuld“ daran haben wieder technische Entwicklungen: Animes werden heute ditigal produziert, ausgestrahlt (HDTV) und verkauft (die analoge LaserDisc wurde in Japan vor etwa 6 Jahren durch die DVD abgelöst). Diese Digitalisierung und immer schneller werdende Computer machten das Untertiteln von Animes um ein Vielfaches einfacher und kostengünstiger. Außerdem kamen seit Ende der 90er-Jahre breitbandige Internet-Anschlüsse in Mode. Das hilft auf vielen Ebenen: die Fansubber können untereinander besser kommunizieren, was vor allem die Zusammenarbeit zwischen Übersetzern und den Videobearbeitern verbessert. Für die normalen Fans ist es leichter, Fansubber überhaupt zu entdecken. Und insbesondere entfällt der ganze Aufwand mit Videokassetten verschicken und kopieren, da die Animes ohne Material- und Portokosten übers Internet transportiert werden können.

Besonders hier in Europa profitiert man davon: wie gesagt wird nach wie vor ein Großteil der Fansubs in den USA erstellt, und das Verschicken von VHS-Kassetten per Post nach Europa war immer eine recht problematische und kostspielige Angelegenheit.

Die neuen Möglichkeiten führten um das Jahr 2000 herum zu einer regelrechten Fansub-Explosion. Mit einem Mal wurde nahezu jede bekanntere Serie in Japan untertitelt. Da die langen Postwege von Japan zu den Fansubbern und von diesen zu den jeweiligen Fans entfielen, konnten Fansubs wesentlich schneller erstellt werden. Noch vor 10 Jahren empfand man einen Anime als aktuell, wenn dieser nicht älter als ein halbes Jahr war – heute vergeht zwischen der Erstausstrahlung im japanischen Fernsehen und der Download-Möglichkeit der untertitelten Episode im Netz manchmal weniger als eine Woche.

Während die technische Qualität der Fansubs (Bildqualität, Tonqualität) ebenfalls stark zunahm und heute oft schon beinahe DVD-Qualität hat, kann man dies von der Übersetzung selbst aber nicht unbedingt behaupten. Berauscht von der Möglichkeit, Anime-Episoden nur wenige Tage nach der Ausstrahlung ins Netz stellen zu können, lieferten sich besonders in den ersten zwei, drei Jahren viele Fansubber ein regelrechtes Rennen – auf Kosten der Sorgfältigkeit. Auch wenn inzwischen wieder mehr Ruhe eingekehrt ist, gibt es trotzdem oft arge Patzer. Spätestens wenn in der „Ghost in the Shell“-TV-Serie von Firmenerpressungen die Rede ist und in den Untertiteln ein „mass naked child event“ vorkommt, sollte sich mancher Fansubber einmal Gedanken über die Bekömmlichkeit diverser Substanzen machen.

Solche Ausfälle gab es freilich auch zu VHS-Zeiten, doch ist es heute schwerer, bei den Fansubs die Perlen unter der großen Menge an Mittelmäßigem herauszufiltern. Das gleiche gilt auch für die Animes selbst: früher wurde nur ein Bruchteil der Anime-Serien untertitelt, folglich konnte man davon ausgehen, dass dies nur die Besten der Besten waren. Heute wird man dagegen auch mit einer Menge an Serien beglückt, auf die man vielleicht auch als hartgesottener Anime-Fan verzichten hätte können…

Hierzulande ist es üblich, englisch lesen zu können. Weil man deswegen auf die Fansubs aus den USA zurückgreifen kann, hat es nie einen so akuten Bedarf an deutschen Fansub gegeben. Deswegen hat es davon auch lange Zeit nie sonderlich viele gegeben; wenige Ghibli-Animes und ein paar andere Anime-Filme wurden als deutsche Fansubs untertitelt, aber das war es dann auch schon so ziemlich.

Erst die letzten zwei, drei Jahre kamen deutsche Fansubs wirklich in Mode.

Zwar ist die deutsche Fansubber-Szene nicht allzu groß und wird es wohl auch nicht werden. Dafür erscheinen hauptsächlich gute Serien in ansehnlicher Qualität, was dem ursprünglichen Gedanken von Fansubs wohl auch näher kommt.

Auch wenn das ganze Thema „Raubkopien“ spätestens nach einigen sehr fragwürdigen Werbekampagnen der Filmindustrie einen unangenehmen Beigeschmack hat, kann man es eigentlich nicht oft genug sagen: auch Anime-Fansubs sind Raubkopien und damit illegal, und jeder, der sich selbst welche anschaut, sollte sich dessen auch bewusst sein.

In den USA beginnt diese Illegalität gerade, sich auf die Fansubber auszuwirken. Früher gab es dort noch ein paar rechtliche Schlupflöcher, die das Risiko für die Fansubber etwas minderten, solange der untertitelte Anime dort noch von keiner Firma lizenziert war. Diese Schlupflöcher gibt es inzwischen nicht mehr. Wichtiger noch: das Phänomen „Fansub“ hat sich so stark verbreitet, dass Fansubs zu einer ernsten Konkurrenz zu den legalen DVD-Veröffentlichungen geworden sind – auch was die technische Qualität angeht. Vor allem aber hat sich die Marktsituation verändert: als Anime noch eine reine Insider-Sache waren, profitierten die Firmen von Fansubs, weil diese Werbung für Animes als solche waren. Inzwischen hat sich Anime so weit etabliert, dass die DVD-Firmen keinen Vorteil mehr in der Existenz von Fansubs sehen. Seit 2004 wird daher auch verstärkt gegen Anime-Downloadseiten vorgegangen, und auch die japanischen Anime-Produzenten beginnen sich, für das Thema zu interessieren und einzugreifen….

Aufsatz im Rahmen der Übung zu „Mensch-Maschine-Interaktion“, WS 2004/05

Drei Jahre nach Einführung des „Commodore 64“ wurde 1985 von „Berkeley Softworks“ (BSW) die Benutzeroberfläche GEOS – „Graphic Environment Operating System“ – veröffentlicht. Es lehnte sich stark an den damaligen Macintosh an, dem ersten erfolgreichen Heimrechner mit grafischer Oberfläche. GEOS musste zwar mit einer deutlich schwächeren Hardware-Plattform auskommen – der 8bittige C=64 hatte eine Taktfrequenz von nur einem knappen MegaHertz und mit 64kb Arbeitsspeicher gerade einmal ein Zehntel dessen, was genug für jeden ist. Dafür war der C=64 aufgrund des wesentlich geringeren Preises um einiges verbreiteter, weswegen man in einer grafischen Oberfläche für diesen viel Potential sah und diese sehr schnell weiterentwickelte.

GEOS war im Gegensatz zu MacOS kein Betriebssystem, sondern wie das später erschienene Windows nur eine grafische Oberfläche. Es hatte viele Funktionen und Elemente, die man schon von MacOS her kannte: Einfache Dialogboxen, Buttons und Pull-Down-Menüs. Dateien konnten mit Drag&Drop verschoben werden und in einen Papierkorb verschobene Dateien wiederhergestellt werden. Das Menü befindet sich wie bei MacOS am oberen Rand des „Desktops“ und variiert von Anwendung zu Anwendung. („deskTop“ war ursprünglich der Titel des Dateimanagers).

In den ersten Versionen gab es „Fenster“, wie wir sie heute kennen, nur in vagen Ansätzen: in der Mitte des Startbildschirms befindet sich ein „Dashboard“, das zwar den Fenstern ähnelt (es gibt eine Titelleiste mit dem Namen des aktuellen Laufwerks und einem Schließen-Button), aber weder verschiebbar noch in der Größe änderbar ist. In den Fenstern befindet sich der Inhalt des jeweiligen Datenträgers, also Programme sowie normale Dateien. Da das Dateisystem der C=64-Floppys von sich aus keine Verzeichnisse unterstützt, gab es anfangs auch unter GEOS keine Unterverzeichnisse. Das war aber auf Grund der ohnehin sehr begrenzten Speicherkapazität der Floppys kaum eine wirkliche zusätzliche Einschränkung. Die Standardansicht des Dateimanagers verwendet Icons für jede Datei. In das „deskTop“-Fenster passen nur acht Dateien auf einmal. Sind mehr als acht Dateien auf einem Datenträger, wird nicht gescrollt, sondern geblättert, indem man ein Icon am links unteren Rand anklickt. Man konnte nur vorwärtsblättern, wobei man von der letzten Seite aus wieder zur ersten kommt. Es ist aber auch möglich, die Icons auszublenden und nur die Dateinamen mit einigen Details wie Dateigröße anzuzeigen – wahlweise sortiert nach Dateiname, Größe oder Dateityp. In diesem Fall wird dann nach unten gescrollt, wenn die Dateien auf einer Seite keinen Platz mehr finden.

Gesteuert wurde GEOS im allgemeinen über ein Gerät, das am Joystick-Port hing; entweder über einen Joystick selbst, oder eine Maus, die einen Joystick emulierte.

Einen großen Reiz von GEOS machte aus, dass es bereits mit einem „What you see is what you get“-Editor ausgeliefert wurde (geoWrite) sowie mit einem Malprogramm (geoPaint), das aber zunächst in Schwarz-Weiß gehalten war. Texte sowie Bilder konnten zwischen Applikationen unter anderem per Drag&Drop ausgetauscht und schließlich auf einem Drucker ausgegeben werden. Mehrere Bitmap-Schriftarten waren bereits vorinstalliert, weitere ließen sich durch extra Schriftpakete nachinstallieren.

Die 1988 veröffentlichte Version 2.0, die unter anderem auch eine Rechtschreibkorrektur mitbrachte, wurde eine Zeitlang direkt mit dem C=64 im Bundle ausgeliefert, was für eine große Verbreitung sorgte. Weitere Applikationen, die mit der Zeit hinzu kamen, waren unter anderem ein Tabellen-Kalkulationsprogramm und eine Datenbank. Wegen der großen Beliebtheit und dem Kult-Status unter vielen Computer-Freaks wird das System auch heute noch weiter gepflegt – TCP/IP- und Modem-Treiber gibt es ebenso wie einen grafischen Browser („The Wave“, entwickelt im Jahr 2000).

Insbesondere letztgenannte Entwicklungen waren aber nur dadurch möglich, dass auch der C=64 hardwaremäßig weiterentwickelt wurde. Neben dem Nachfolgemodell C=128 gab es später auch fortschrittlichere Speichermedien als die Floppy (oder gar die alte Datasette). Noch wichtiger waren Speichermodule, mit denen man den C=64 über den User-Port erweitern konnte und noch später die externe CPU-Erweiterung „SuperCPU“, mit der man den C=64 mit bis zu 20MHz ausstatten konnte.

GEOS wurde stets dahingehend weiterentwickelt, auch diese neue Hardware zu unterstützen. Uns zwar aus gutem Grund: es mag zwar erstaunlich sein, was das System aus einem Standard-C=64 herausholt, doch die oft langen Ladezeiten von der Floppy waren extrem störend. Die Beschränkungen mussten ohnehin schon mit einer ganzen Reihe an Tricks umgangen werden – beispielsweise war das ganze System auf zwei Floppy-Disks verteilt, die man während dem Betrieb gelegentlich wechseln musste. Erst mit einer Speichererweiterung konnten nennenswert Daten gecached werden, was langsame Disketten-Zugriffe vermied. In Verbindung mit diesen Speichererweiterungen bot GEOS außerdem die Möglichkeit, Ramdisks anzulegen.

Was nicht bzw. nur eingeschränkt möglich war, ist Multi-Tasking. Der Grund dafür ist wohl in der Hardware zu suchen, die dafür schlichtweg nicht ausgereicht hätte. Einige kleine Tools bildeten dabei aber eine Ausnahme: Taschenrechner, Notizblock und Ähnliches konnten ab der Version 2.0 aus den meisten Anwendungen heraus kurzzeitig aufgerufen werden, ohne das ursprüngliche Programm zu beenden.

Einen großer Schritt nach Vorne war zumindest aus technischer Sicht die 1993 nur in Deutschland (von Markt&Technik) veröffentlichte Version 2.5: der Dateimanager „deskTop“ wurde durch „TopDesk“ ersetzt, der deutlich am Konzept der Fenster feilte: bis zu vier Fenster waren ab dann möglich, und diese auch vergrößerbar und verschiebbar. Außerdem wurden erstmals Unterverzeichnisse unterstützt – wenn auch auf eine recht kuriose Weise, die zu keinem anderen System kompatibel war. Auch TopDesk wird noch weiterentwickelt, und unterstützt (über einige Hardware-Tricksereien) auch aktuellere Geräte wie CD-ROMS, und ist inzwischen sogar farbig. Insbesondere in den letzten zehn Jahren haben sich die Weiterentwicklungen allerdings sehr stark aufgesplittet. Neben der genannten deutschen Version 2.5 (die im Kern eigentlich ein reguläres 2.0 war, das um einige Programme wie das eben genannte TopDesk aufpoliert war) gibt es mehrere parallele, voneinander unabhängige Weiterentwicklungen. Creative Micro Designs veröffentlichte 1996 die Erweiterung „gateWay“ (u.a. 2-Prozess-Multitasking) für den C=64/128, 1998 folgte „Wheels“ von Maurice Randall (Unterstützung für SuperCPU-Beschleunigung), 1999 kam von MegaCom das Upgrade „MP3“. Daneben wurde auch noch versucht, GEOS auf andere Hardwareplatformen zu portieren und dort weiterzuentwickeln. Neben einer Portierung für den Macintosh ist vor allem „PC-Geos“ erwähnenswert, das für den PC entwickelt wurde, und unter DOS lief. Die Tatsache, dass es den damaligen Windows-Versionen sogar überlegen war, hat freilich nicht genügt, um langfristig auf dem „feindlichen Boden“ MS-DOS zu bestehen. Dafür war ihm auf diversen mobilen Geräten ein etwas länger währender Erfolg beschert. Das ursprüngliche GEOS C=64 Version 2.0 ist seit einem knappen Jahr (Februar 2004) sogar kostenlos verfügbar – wenn auch weiterhin als proprietäre Software.

War GEOS für den C=64 nun ein Durchbruch oder gar eine „Revolution“, wie es von Fans manchmal betitelt wird? Nein, eher nicht. Man könnte es als ein „technisches Wunder“ bezeichnen, was GEOS auf den begrenzten Hardwarevoraussetzungen herausholte – eine Sparsamkeit, die man schon wenig später nur noch selten antraf. Trotzdem reichte dies in der Praxis nicht aus, um wirklich produktiv mit GEOS zu arbeiten, zumindest nicht auf dem handelsüblichen C=64/128. Insbesondere die langen Wartezeiten beim Laden von Floppy auch nach dem Start machten das Arbeiten zur Geduldsprobe. Noch ein weiteres Problem ergab sich aus den Floppys, in Verbindung mit der damals noch viel größeren Raubkopier-Problematik: Berkeley Softworks schaffte das Kunststück, die Floppys mit einem Kopierschutz auszustatten, der wirklich viele Jahre nicht geknackt wurde. Da die Datenträger aber wie alle anderen Floppys des C=64 extrem fehleranfällig waren, bedeutete dies trotz einer (ebenfalls anfälligen) beigelegten Sicherheitskopie, dass man schnell in der Situation war, das System nicht mehr booten zu können. Zwar gab es Umtauschmöglichkeiten, aber letztlich bedeutete die nicht vorhandene Möglichkeit, sich selbst Sicherheitskopien anlegen zu können, eine ständige Quelle für Unannehmlichkeiten und Ärgernisse. Konzeptionell bot GEOS auch wenig Neues; man orientierte sich eben sehr stark an MacOS. Insofern war GEOS nicht der große Durchbruch grafischer Oberflächen auf dem Massenmarkt, bot aber zumindest vielen, die sich damals keinen Mac leisten konnten, ein frühes Bild davon, was viel später dann wirklich große Verbreitung fand.

Arbeit in „Theorien und Modelle in der Kommunikationswissenschaft“, SS 2003

Das „Elaboration Likelihood Model“ (ELM) von Richard Petty und John T. Cacioppo (1981) beschreibt den Prozess einer möglichen Meinungsänderung in Folge einer persuasiven Botschaft und ist bis heute eines der anerkanntesten Modelle auf dem Gebiet der Medien-Wirkungsforschung.

Im Kern geht es davon aus, dass es zwei unterschiedliche Arten der Verarbeitung einer persuasiven Botschaft gibt. In der „zentralen Route“ findet eine eingehende Auseinandersetzung mit den Argumenten der Botschaft statt, der Rezipient macht sich ein differenziertes Bild der Sachlage. In der „peripheren Route“ dagegen findet nur eine sehr oberflächliche Beschäftigung mit den Inhalten statt, man kommt eher an Hand von äußerlichen Merkmalen zu seiner Meinung.

Das ELM beschreibt nicht nur diese beiden „Routen“, sondern auch die Voraussetzungen, die zum Beschreiten der jeweiligen Route gegeben sein müssen und welche Faktoren dies beeinflussen. Außerdem wird gezeigt, welche Eigenschaften der Nachricht sich in Abhängigkeit von der beschrittenen Route aus welche Weise auf den Persuasionsprozess auswirken – es kommt durchaus vor, dass sich eine Eigenschaft bei peripherer Verarbeitung positiv, bei elaborierter Verarbeitung aber negativ auswirken kann.

In dieser Arbeit soll zunächst der Begriff des Involvements geärt werden, der eines der zentralen Konzepte des Elaboration Likelihood Modells ist. Es folgt eine genauere Beschreibung des Modells selbst, wobei zuerst die beiden Arten der Informationsverarbeitungen charakterisiert werden. Anschließend wird erläutert, welche Voraussetzungen es für die elaborierte Auseinandersetzung gibt und welche Faktoren diese begünstigen können. Eine kurze Kritik über das Modell, ein Ausblick auf die Zukunft und die knappe Vorstellung einer aktuellen Studie, die auf dem ELM basiert, sollen diese Arbeit abrunden.

Involvement – zu deutsch die „Beteiligung“, die „Eingebundenheit“ – ist kein für sich stehendes Modell in der Kommunikationsforschung, sondern ein Konzept, das von Modellen einbezogen wird um unterschiedliche Informationsverarbeitungsprozesse beim Rezipienten auszudifferenzieren. Es wird zwischen hohem und niedrigem Involvement unterschieden – ersteres ist im ELM für eine intensive Auseinandersetzung mit der Medienbotschaft förderlich, letztere hinderlich. Obwohl oder gerade weil dies so eingängig und alltäglich klingt, stellt das Involvement-Konzept die Forscher doch vor ein gewisses Problem: wie ist Involvement nun genau zu definieren, wie wird es in Versuchsreihen operationalisiert? Verschiedenen Forschungsrichtungen gehen dabei völlig unterschiedlich vor. Die wichtigsten Einsatzbereiche sind nach Schenk (2002, S. 265-267):

Diese Definitionen sind natürlich nicht die einzigen, zumindest aber mit die am häufigst verwendeten.

Unterschieden wird beispielsweise noch zwischen Personen mit emotions- und mit erkenntnisbezogenem Involvement; erstere können durch emotionale Ansprache zwar langsamer, dafür aber tendenziell stabiler beeinflusst werden, durch kognitive Ansprache etwas schneller aber weniger stabil – bei Personen mit erkenntnisbezogenem Involvement ist dies natürlich genau anders herum (FOCUS-Lexikon: Elaboration Likelihood Model).

Auch herrscht noch keine Einigkeit darüber, ob bei Involvement von einem Zustand auszugehen ist oder von einem kontinuierlichen Prozess.

Das Involvement-Konzept hat also sehr verschiedene Operationalisierungen erfahren, und auch wenn diese Unschärfe gelegentlich kritisiert wird, gewährleistet vermutlich gerade das die breite Anwendbarkeit.

Das ELM versteht unter der Zentralen Route die elaborierte Informationsverarbeitung, bei der sich der Rezipient intensiv mit einer Information, i.a. einer Medienbotschaft, auseinandersetzt. Er prüft die enthaltenen Argumente, erinnert sich an andere Argumente, zieht selbst Schlussfolgerungen und macht sich ein differenziertes Bild von der Sachlage. Am Ende kann eine Einstellungsänderung seitens des Rezipienten erfolgen, muss aber natürlich auch nicht. Sollte eine solche erfolgen, ist diese also nicht direkt durch die Medienbotschaft selbst entstanden, sondern durch das gedankliche Auseinandersetzen mit ihr. Dem Rezipienten wird ein hohes Maß an Eigenaktivität zugesprochen. In der zentralen Route geht das ELM also von ähnlichen Voraussetzungen aus wie sein Vorgängermodell der „Cognitive Responses“ (Schenk, 2002, S. 253-254).

Das ELM erweitert den Informationsverarbeitungsprozess aber noch um die „Periphere Route“, bei der keine elaborierte Verarbeitung stattfindet, sondern lediglich äußerliche Reize ausgewertet werden, die nicht mit dem eigentlichen Thema zu tun haben. Auch dieser Weg kann allerdings zu einer Meinungsänderung führen. Dass es diese zweite Art der Verarbeitung gibt, klingt nur allzu einleuchtend: da eine elaborierte Auseinandersetzung mit Informationen einen nicht unerheblichen geistigen Aufwand bedeutet und wir täglich mit einer nahezu unüberschaubaren Fülle an Informationen konfrontiert sind, ist es durchaus sinnvoll, sich in weniger relevanten Fällen (low involvement) gewisser Heuristiken zu bedienen. Eine periphere Verarbeitung bedarf, anders als eine zentrale, keines großen Vorwissens, keiner großer Anstrengung und Motivation. Da die eventuell daraus entstehende Meinungsänderung allerdings nicht auf wirklicher Auseinandersetzung mit den Inhalten basiert, ist sie aber auch gegenüber späteren Beeinflussungen wenig resistent. Meinungsänderungen in Folge elaborierter Auseinandersetzung mit dem Thema kommen nur deutlich langsamer und schwerer zu Stande, sind aber in das persönliche Geflecht aus Einstellungen, Normen und Werten integriert und weisen daher eine hohe Widerstandskraft auf und sind dauerhaft.

Wenn man von der zentralen Route spricht und dabei von elaborierter Auseinandersetzung mit dem Thema die Rede ist, meint man dabei meistens implizit, dass dies auch objektiv geschieht. Das muss allerdings nicht zwingend so sein. Das ELM lässt durchaus auch eine voreingenommene Informationsverarbeitung („biased processing“) zu (Lien, 2000, S. 301-302). In diesem Fall geht man sehr stark subjektiv an die Argumentation heran – wohl gesonnene Argumente werden als wichtiger empfunden, Gegenargumente abgeschwächt oder umgedeutet.

Voreingenomme Informationsverarbeitung tritt meist dann auf, wenn die betreffende Person zum diskutierten Thema bereits vor dem Kontakt mit der persuasiven Botschaft intensiv einen bestimmten Standpunkt einnimmt und nicht gewillt ist, diesen aufzugeben.

Auch wenn man über die persuasive Absicht des Kommunikators gewarnt wurde und ggf. seine Argumente bereits kennt, neigt man dazu, die Sache weniger objektiv anzugehen. Insbesondere neigt man zur Gegenargumentation, wenn man sich vom Kommunikator in eine bestimmte Richtung gedrängt fühlt, dieser einem scheinbar gar keine Wahl lassen will, ob man seinen Standpunkt einnimmt oder nicht.

Letztlich kann es besonders bei Reden auch zur voreingenommen Informationsverarbeitung kommen, wenn kritische Kommentare aus dem Publikum kommen, auf die der Redner nicht souverän reagiert.

Auch wenn bei dieser Herangehensweise der Versuch, die eigentliche Aussage der Botschaft zu erfassen stark in den Hintergrund gedrängt wird, handelt es sich doch um die zentrale Route. Diese behauptet ja nicht, dass man durch die elaborierte Auseinandersetzung mit der Botschaft automatisch auch zu dem richtigen Ergebnis kommt (das „richtige“ Ergebnis würde wegen unterschiedlicher persönlicher Gewichtung der Argumente ohnehin von Person zu Person anders aussehen). Entscheidend ist, dass man sich mit den Argumenten auseinandersetzt (Frey, Stahlberg, 1993, S. 327-260).

Damit man sich auf der zentralen Route mit einem Thema beschäftigt, muss zum einen die Motivation dafür vorhanden sein, zum anderen aber auch die persönliche Fähigkeit dazu.

Die Motivation zur Elaboration wird maßgeblich vom Involvement bestimmt, insbesondere also der Eindruck der persönlichen Relevanz des Themas. Dieser Eindruck kann durch äußere Reize verstärkt werden. Beispielsweise kann er bereits dadurch erhöht werden, dass in die zweite Person („Du“) gewechselt wird, der Rezipient also direkt angesprochen wird. In der Werbung wird versucht, die Auseinandersetzung mit den Werbebotschaften dadurch zu fördern, dass Bezüge zum Rezipienten hergestellt werden1. Außerdem steigt die Motivation, sich mit einem Thema auseinander zu setzen, wenn die Anzahl der Quellen, die selbiges thematisieren, hoch ist (Littlejohn, 2002). Auch haben Menschen einen unterschiedlich hohen Bedarf nach Kognitionen (Eckert, 1997, S. 606) – dies wirkt sich natürlich unmittelbar auf die Motivation aus. Die Motivation, sich elaboriert ein Urteil über etwas zu bilden, sinkt, wenn man selbst davon betroffen ist – z.B. wenn es ein Urteil über eine Gruppe zu bilden gilt, der man selbst angehört.

Neben der Motivation müssen natürlich auch die persönlichen kognitiven Fähigkeiten dazu vorhanden sein, um sich elaboriert mit einem Thema befassen zu können. Besonders wichtig ist das Vorwissen, das die jeweilige Person zum Thema mitbringt und auf das er auch aktiv zugreifen kann. Littlejohn veranschaulicht das sehr schön (Littlejohn, 2002, S. 133): „Most students would be more critical of a speech on fashion trends than one on quarks and electrons“ (etwa: „Die meisten Schüler werden einen Vortrag über Modetrends kritischer beurteilen als einen über Quarks und Elektronen.“)

Es gibt noch weitere Faktoren, die die Wahrscheinlichkeit des Elaborierens beeinflussen, die sich grob in Nachrichten- und Rezipientenfaktoren unterteilen lassen.

Auf der Seite der Botschaft können Wiederholungen der Kernaussagen und damit verbunden ein angemessenes Tempo der Informationsaufnahme das Verstehen begünstigen. Insbesondere bei komplexen Themen und einer weniger informierten Zielgruppe ist es wichtig, Argumente zu wiederholen und das Tempo nicht zu hoch zu wählen. Das ist ein Balanceakt: bei zu häufiger Wiederholung oder zu langsamen Tempo entstehen „Ware-Out“-Effekte, Langeweile. Wird ein Argument zu oft gebracht, kann sich der Rezipient gar gedrängt fühlen – voreingenommene Elaboration bzw. verstärkte Gegenargumentation sind das Ergebnis. Ebenso verhält es sich mit der Frage, ob man Schlussfolgerungen explizit ziehen sollte – ist davon auszugehen, dass der Rezipient in der Lage ist, dies selbst zu tun, ist es effektiver, ihn das auch zu lassen; wenn nicht, sollten Schlussfolgerungen explizit gezogen werden.

Auch die Art des Mediums, in dem die Botschaft vorzufinden ist, können die Wahrscheinlichkeit des Elaborierens erhöhen oder senken. Generell fördern Zeitungen bzw. Zeitschriften die elaborierte Informationsverarbeitung, das Fernsehen dagegen ist ein nahezu ausschließlich peripheres Medium. Das Internet gehört zu den eher kognitiven Medien, das Radio liegt irgendwo in der Mitte, aber mit Tendenz richtung peripher. Dies wird durch den bereits erwähnten Geschwindigkeits-Faktor verstärkt: Bei Print- und Onlinemedien kann sich jeder Rezipient das Tempo der Informationsaufnahme selbst vorgeben, wohingegen man sich bei TV und Radio nach den Vorgaben des Mediums richten muss (Schenk, 2002, S. 260).

Hohe Glaubwürdigkeit der Quelle und Expertenmeinungen können bei mittelhohem Involvement zum Elaborieren anregen (Schenk, 2002, S. 260-261).

Auf der Seite des Rezipienten sind es in erster Linie Faktoren, die die momentane Befindlichkeit des Rezipienten betreffen. Besondere Beachtung gilt dabei Untersuchungen, inwieweit die Wahrscheinlichkeit des Elaborierens von der Stimmung abhängt. Allgemein wird davon ausgegangen, dass eine gute Stimmung eine elaborierte Auseinandersetzung mit dem Thema eher behindert (Batra, Stayman, 1990). Unter manchen Umständen kann sie aber wiederum förderlich sein, z.B. wenn der Rezipient davon ausgehen kann, dass die gute Stimmung dadurch nicht beeinträchtigt wird (Wegener et al, 1995). Gerade dieser Punkt scheint noch genauerer Forschung und Systematisierung zu bedürfen.

Befindet man sich in einem Stadium starker Erregung, neigt man zu peripherer Informationsverarbeitung, eine elaborierte Auseinandersetzung wird also eher behindert (Lien, 2000, S. 303). Dass es die elaborierten Informationsverarbeitung außerdem behindert, wenn man von der „Außenwelt“ abgelenkt wird, dürfte klar sein.

Daneben hat auch die Körperhaltung einen Einfluss auf die Wahrscheinlichkeit des Elaborierens: Liegt oder sitzt man bequem, fällt es einem leichter, sich intensiv mit einem Thema zu beschäftigen, als wenn man steht oder geht (Petty, 1983, S. 209-222).

Das Elaboration Likelihood Modell besagt nicht nur, dass es zwei Routen in der Informationsverarbeitung gibt und welche Route wann eingeschlagen wird, sondern trifft auch Aussagen darüber, wie die Persuasionskraft von Botschaften davon beeinflusst wird, welche Route eingeschlagen wird.

Verschiedenste Faktoren haben einen Einfluss darauf, wie überzeugend eine Botschaft auf einen Rezipienten wirkt. Eine Betrachtung, die eine möglichst vollständige Liste dieser Faktoren anstrebt, würde diesen Rahmen natürlich sprengen. Interessant in Hinblick auf das ELM sind inbesondere jene Faktoren, die sich bei zentraler und peripherer Verarbeitung unterschiedlich auswirken.

Der komplette Bereich der äußeren Reize spielt wie bereits erwähnt nahezu exklusiv in der peripheren Route eine Rolle. Dazu gehören Punkte wie schöne Bilder, Musik, Kameraperspektive und dergleichen mehr (Lien, 2000, S. 304-304).

Auch „Aufwärtsvergleiche“ werden zu den peripheren Reizen gezählt. Von Aufwätsvergleichen ist z.B. die Rede, wenn die Tatsache, dass eine bereits bekannte Person einen bestimmten Standpunkt einnimmt bzw. ein Produkt verwendet, als Argument für diesen Standpunkt bzw. dieses Produkt verwendet wird (Schenk, 2002, S. 261). Dies muss sich natürlich nicht nur auf Personen beziehen.

Die Anzahl der Argumente kann unterschiedliche Auswirkungen auf die Persuasionskraft haben. Wird die Botschaft rein peripher ausgewertet, zählt die reine Anzahl als Reiz. Da keine genauere Auseinandersetzung mit den einzelnen Argumenten erfolgt, spielt es folglich auch keine Rolle, ob es sich dabei um starke oder schwache Argumente handelt – die reine Masse zählt. Wird die Botschaft dagegen elaboriert verarbeitet, kann es dagegen sogar kontraproduktiv sein, wenn um jeden Preis möglichst viele Argumente unabhängig von deren Qualität untergebracht werden – hat man starke Argumente, sollte sich die Botschaft auf diese konzentrieren, die Überzeugungskraft sinkt eher, wenn diese mit schwachen Argumenten „verwässert“ werden (Schenk, 2002, S. 261).

Der selbe Sachverhalt hat natürlich auch eine Wirkung auf die Überzeugungskraft der einzelnen Argumente an sich: während auf der peripheren Route praktisch jedes Argument etwa gleich viel, mäßig viel, zur Überzeugung beiträgt, haben bei der zentralen Route starke Argumente naturgemäß mehr Wirkung als schwache. Botschaften mit eher schwachen Argumenten wirken in der zentralen Route also eher weniger überzeugend, während bei Botschaften mit viel starken Argumenten bei Verarbeitung in der zentralen Route sogar eine höhere Persuasionsrate entstehen kann als bei peripherer Verarbeitung (die anfängliche Aussage, Meinungsänderungen durch die zentrale Route kämen nur viel langsamer und schwerer zu Stande, ist dahingehend zu relativieren) (Schenk, 2002, S. 257-258).

Verfasst man eine persuasive Botschaft, ist auch bei der Entscheidung, ob die Argumentation einseitig gehalten werden oder Pro- und Kontraargumente berücksichtigen soll, zu beachten, ob eher die periphere oder die zentrale Route angesprochen werden soll. Bei elaborierter Verarbeitung erhöht zweiseitige Argumentation die Glaubwürdigkeit der Botschaft, wirkt sich also positiv auf die Überzeugungskraft der Botschaft aus. Bei peripherer Verarbeitung kann die Einbeziehung von Gegenargumenten der Gesamtwirkung eher abträglich sein. Dieser Punkt zeigt sehr schön, wie auch frühere Ergebnisse der Persuasionsforschung mit dem ELM interpretieren lassen: ähnliche Befunde gab es bereits in den Yale Studies (Hovland et al., 1949).

Quellenfaktoren, insbesondere die Glaubwürdigkeit der Quelle sind hauptsächlich periphere Reize. Ist die Quelle glaubwürdig, steigt bei peripherer Verarbeitung die Überzeugungskraft der Botschaft, bei elaborierter Verarbeitung bleibt sie dagegen nahezu unverändert (Schenk, 2002, S. 260-261).

Die Stimmung, in der sich der Rezipient gerade befindet, hat ebenfalls einen nicht unwesentlichen Einfluss darauf, wie eine Botschaft auf ihn wirkt. In der peripheren Route ist die Stimmung ein äußerer Reiz – positive Stimmung wirkt sich unmittelbar in eine positivere Einstellung dem Thema bzw. dem Produkt gegenüber aus. Aber auch bei elaborierter Auseinandersetzung kann sich eine positive Stimmung auswirken: (unabhängig von der bereits erwähnten Tatsache, dass eine sehr positive Stimmung das Elaborieren eher unwahrscheinlicher macht) die Stimmung beeinflusst die Gedanken, die man sich zum Thema macht, so dass man in diesem Fall eher zu positiven Gedanken neigt und damit auch das Gesamturteil etwas positiver ausfallen dürfte – die Stimmung wirkt dann also nur indirekt auf die Überzeugungskraft.

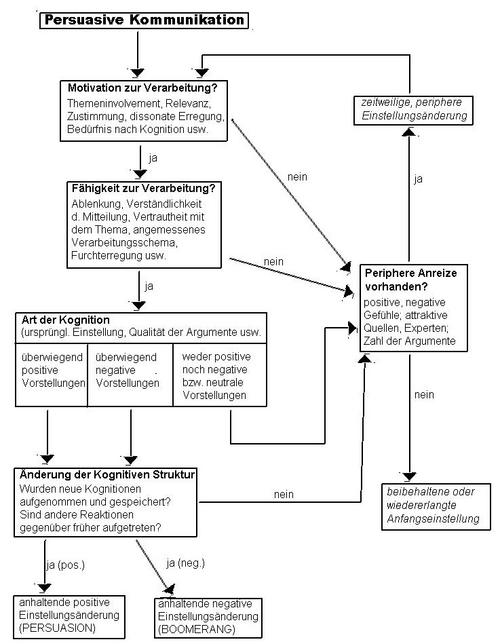

Elaboration Likelihood-Modell nach PETTY, R.E., J.T. CACIOPPO, 1986, S.4

Grafik aus Schenk, M. (2002). Medienwirkungsforschung (S. 255). Tübingen: J.C.B. Mohr

Kleine Änderungen zur Vermeidung von Missverständnissen vorgenommen

(Verschiebung eines falsch gesetzten Pfeils)

Das dargestellte Modell soll die Grundkonzepte des ELM nocheinmal visualisieren. Die linke Spalte stellt die zentrale Route dar, die rechte die periphere. Das Flussdiagramm macht deutlich, dass zu einer elaborierten Auseinandersetzung sowohl die Motivation, als auch die Fähigkeit zur Verarbeitung vorhanden sein muss. Nur wenn beides vorhanden ist, die Botschaft entweder überwiegend positive oder negative Kognitionen hervorruft und diese letztlich auch in die persönliche kognitive Struktur integriert wird, kann eine dauerhafte Einstellungsänderung erfolgen. Ansonsten ist bestenfalls eine kurzfristige Meinungsänderung auf der peripheren Route möglich. Diese jeweilige Meinungsänderung muss natürlich nicht unbedingt im Sinne der persuasiven Botschaft sein – auch der Boomerang-Effekt, das Einnehmen einer der Botschaft entgegengesetzten Haltung, ist möglich.

Nach über 20 Jahren zählt das Elaboration Likelihood Modell nach wie vor zu den verbreitetsten seiner Art. Das Grundkonzept des ELM, die Unterscheidung zwischen elaborierter und peripherer Informationsverarbeitung, hat allgemeine Anerkennung gefunden. Noch nicht geklärt ist allerdings, ob diese beiden Routen tatsächlich so unabhängig voneinander existieren, wie dies im ELM beschrieben wird (die Verfasser relativierten diese strikte Trennung ohnehin recht schnell wieder). Wahrscheinlicher ist, dass beide Routen in gewissem Sinne gleichzeitig eingeschlagen werden, oder sich zumindest regelmäßig abwechseln, wie dies z.B. im Modell der Heuristisch-Systematischen Informationsverarbeitung der Fall ist. Wie dies genau erfolgt, wird sicherlich noch Stoff zukünftiger Forschungen sein.

Interessant ist, dass das ELM weniger versucht, das Ergebnis persuasiver Kommunikation zu beschreiben, sondern vielmehr den Prozess, der dazu führt. Diese prozessorientierte Herangehensweise deckt sich auch mit vielen anderen Forschungen der aktuellen Werbeforschung.

Das ELM wurde viel verwendet, um Effekte der Werbung und des Marketings zu erklären und hat darin gute Dienste geleistet: es stellt eine gute Basis für Betrachtungen dar, ist im Kern einfach zu verstehen und auch erweiterbar. Neben der Werbung ist es auch für viele andere Bereiche der Kommunikationsforschung anwendbar.

Als Beispiel dafür, wie das ELM heutzutage angewendet wird, sei die Studie „eELM: A Replication and Refinement of the Elaboration Likelihood Model for Computer mediated environments“ (Hershberger, 2002), die zu den jüngsten Anwendungen des ELMs gehört. Untersucht wird die Werbewirkung im Internet. Das ELM wird um mehrere Faktoren erweitert, insbesondere um „Erfahrung mit dem Netz“ („web experts“ zeigen sich resistenter gegenüber peripheren Reizen bei Bannerwerbung), und „Vertrauen ins Netz“ (differenziert in Vertrauen in andere Benutzer, in Organisationen und in die Technik) und der Einfluss verschiedener Eigenschaften von Bannerwerbung auf den Persuasionsprozess untersucht (neben Attributen wie Farbe, Animation und Informationsgehalt auch Kontexteigenschaften wie die Einstellung des Rezipienten zur Website, auf der das Banner platziert ist). Dieses Beispiel soll verdeutlichen, wie das ELM ohne Probleme erweitert und spezialisiert werden kann, um weitere Formen der Werbewirkung zu untersuchen.

In vielen Bereichen sind aber noch weitere Forschungen notwendig. Als Beispiel sei nur der Einfluss der Stimmung auf den Persuasionsprozess genannt. Auch die Abhängigkeiten der einzelnen Faktoren untereinander sind noch nicht völlig erkundet.