Arbeit in „Theorien und Modelle in der Kommunikationswissenschaft“, SS 2003

Übersicht

Das „Elaboration Likelihood Model“ (ELM) von Richard Petty und John T. Cacioppo (1981) beschreibt den Prozess einer möglichen Meinungsänderung in Folge einer persuasiven Botschaft und ist bis heute eines der anerkanntesten Modelle auf dem Gebiet der Medien-Wirkungsforschung.

Im Kern geht es davon aus, dass es zwei unterschiedliche Arten der Verarbeitung einer persuasiven Botschaft gibt. In der „zentralen Route“ findet eine eingehende Auseinandersetzung mit den Argumenten der Botschaft statt, der Rezipient macht sich ein differenziertes Bild der Sachlage. In der „peripheren Route“ dagegen findet nur eine sehr oberflächliche Beschäftigung mit den Inhalten statt, man kommt eher an Hand von äußerlichen Merkmalen zu seiner Meinung.

Das ELM beschreibt nicht nur diese beiden „Routen“, sondern auch die Voraussetzungen, die zum Beschreiten der jeweiligen Route gegeben sein müssen und welche Faktoren dies beeinflussen. Außerdem wird gezeigt, welche Eigenschaften der Nachricht sich in Abhängigkeit von der beschrittenen Route aus welche Weise auf den Persuasionsprozess auswirken – es kommt durchaus vor, dass sich eine Eigenschaft bei peripherer Verarbeitung positiv, bei elaborierter Verarbeitung aber negativ auswirken kann.

In dieser Arbeit soll zunächst der Begriff des Involvements geärt werden, der eines der zentralen Konzepte des Elaboration Likelihood Modells ist. Es folgt eine genauere Beschreibung des Modells selbst, wobei zuerst die beiden Arten der Informationsverarbeitungen charakterisiert werden. Anschließend wird erläutert, welche Voraussetzungen es für die elaborierte Auseinandersetzung gibt und welche Faktoren diese begünstigen können. Eine kurze Kritik über das Modell, ein Ausblick auf die Zukunft und die knappe Vorstellung einer aktuellen Studie, die auf dem ELM basiert, sollen diese Arbeit abrunden.

Involvement

Involvement – zu deutsch die „Beteiligung“, die „Eingebundenheit“ – ist kein für sich stehendes Modell in der Kommunikationsforschung, sondern ein Konzept, das von Modellen einbezogen wird um unterschiedliche Informationsverarbeitungsprozesse beim Rezipienten auszudifferenzieren. Es wird zwischen hohem und niedrigem Involvement unterschieden – ersteres ist im ELM für eine intensive Auseinandersetzung mit der Medienbotschaft förderlich, letztere hinderlich. Obwohl oder gerade weil dies so eingängig und alltäglich klingt, stellt das Involvement-Konzept die Forscher doch vor ein gewisses Problem: wie ist Involvement nun genau zu definieren, wie wird es in Versuchsreihen operationalisiert? Verschiedenen Forschungsrichtungen gehen dabei völlig unterschiedlich vor. Die wichtigsten Einsatzbereiche sind nach Schenk (2002, S. 265-267):

- Involvement als Persönlichkeitsmerkmal: Personen mit „high involvement“ neigen grundsätzlich dazu, sich über Entscheidungen mehr Gedanken zu machen. Meist sind dies Personen mit höherem Bildungsgrad, die in ein größeres soziales Netzwerk eingebunden sind und intensiv die Medien nutzen. Analog hierzu ist die Wissenskluftforschung zu sehen, die ebenfalls davon ausgeht, dass es Personen gibt, die stärker von Medien Gebrauch machen als andere und daher auch mehr Vorteile aus dem gestiegenen Medienangebot ziehen.

- Involvement als Stimulus-Eigenschaft: Diese Interpretation findet vor allem im Marketing Einsatz. Involvement bezieht sich hier nicht auf den Rezipienten, sondern auf das beworbene Produkt. Stark involvierende Produkte sind demnach solche, die von sich aus den Käufer dazu ermutigen, sich vor der Kaufentscheidung erst einmal genauer Gedanken darüber zu machen. Dies ist meist dann der Fall, wenn der Erwerb ein hohes finanzielles oder soziales Risiko darstellt oder das Produkt einen gewissen Identifikationscharakter besitzt. Bei hoch involvierenden Produkten wie z.B. Autos oder Computern muss die Werbung also auch mehr auf diese gedankliche Auseinandersetzung abzielen als z.B. für normale Haushaltswaren (low involvement products).

- Involvement als individuell interner Zustand: Damit wird das Einnehmen eines bestimmten Standpunktes und das Vorhandensein bestimmter Assoziationen bezeichnet. Beim Einsatz im Marketing wird von hohem Involvement oft schon dann gesprochen, wenn gewisse Produkt- und Marken-Assoziationen überhaupt vorhanden sind. Sherif et al. verwendeten das Konzept des Ego-Involvements, nach dem hohes Involvement erst dann gegeben ist, wenn ein Standpunkt mit einer gewissen Intensität vertreten wird – das Einnehmen alleine genügt noch nicht (Sherif, 1967, S. 133). Hier geht es aber meist weniger um Produkte und Marken, sondern um allgemeine Einstellungen und Werte. Hohes Ego-Involvement äußert sich darin, dass neue Informationen und Argumente schneller abgewiesen werden, wogegen man bei niedrigem Ego-Involvement eine höhere Toleranz gegenüber abweichenden Argumenten besitzt (Sherif et al., 1965, S. 234). Das persönliche Interesse an einem Thema wird oft als Operationalisierung von Ego-Involvement verwendet, auch wenn dies nicht ganz zutreffend ist: hohes Interesse bedeutet nicht unbedingt eine intensive Einnahme eines Standpunktes.

- Involvement als Stimulus Salience: Involvement wird hier als persönlich empfundene Wichtigkeit eines Objekts bzw. eines Sachverhalts interpretiert. Entscheidend ist nicht unbedingt, ob es wichtig ist, sondern ob es so empfunden wird. Es ist z.B. bei einem Studenten beim Thema Studiengebühren davon auszugehen, dass höheres Involvement anzutreffen ist, wenn auch die eigene Universität betroffen ist. Diese Definition des Involvements ist für die weitere Betrachtung des ELMs die wichtigste; Petty und Cacioppo legten ihren Betrachtungen ebenfalls diese Operationalisierung zu Grunde.

Diese Definitionen sind natürlich nicht die einzigen, zumindest aber mit die am häufigst verwendeten.

Unterschieden wird beispielsweise noch zwischen Personen mit emotions- und mit erkenntnisbezogenem Involvement; erstere können durch emotionale Ansprache zwar langsamer, dafür aber tendenziell stabiler beeinflusst werden, durch kognitive Ansprache etwas schneller aber weniger stabil – bei Personen mit erkenntnisbezogenem Involvement ist dies natürlich genau anders herum (FOCUS-Lexikon: Elaboration Likelihood Model).

Auch herrscht noch keine Einigkeit darüber, ob bei Involvement von einem Zustand auszugehen ist oder von einem kontinuierlichen Prozess.

Das Involvement-Konzept hat also sehr verschiedene Operationalisierungen erfahren, und auch wenn diese Unschärfe gelegentlich kritisiert wird, gewährleistet vermutlich gerade das die breite Anwendbarkeit.

Das Elaboration Likelihood Modell

Zentrale Route, Periphere Route

Das ELM versteht unter der Zentralen Route die elaborierte Informationsverarbeitung, bei der sich der Rezipient intensiv mit einer Information, i.a. einer Medienbotschaft, auseinandersetzt. Er prüft die enthaltenen Argumente, erinnert sich an andere Argumente, zieht selbst Schlussfolgerungen und macht sich ein differenziertes Bild von der Sachlage. Am Ende kann eine Einstellungsänderung seitens des Rezipienten erfolgen, muss aber natürlich auch nicht. Sollte eine solche erfolgen, ist diese also nicht direkt durch die Medienbotschaft selbst entstanden, sondern durch das gedankliche Auseinandersetzen mit ihr. Dem Rezipienten wird ein hohes Maß an Eigenaktivität zugesprochen. In der zentralen Route geht das ELM also von ähnlichen Voraussetzungen aus wie sein Vorgängermodell der „Cognitive Responses“ (Schenk, 2002, S. 253-254).

Das ELM erweitert den Informationsverarbeitungsprozess aber noch um die „Periphere Route“, bei der keine elaborierte Verarbeitung stattfindet, sondern lediglich äußerliche Reize ausgewertet werden, die nicht mit dem eigentlichen Thema zu tun haben. Auch dieser Weg kann allerdings zu einer Meinungsänderung führen. Dass es diese zweite Art der Verarbeitung gibt, klingt nur allzu einleuchtend: da eine elaborierte Auseinandersetzung mit Informationen einen nicht unerheblichen geistigen Aufwand bedeutet und wir täglich mit einer nahezu unüberschaubaren Fülle an Informationen konfrontiert sind, ist es durchaus sinnvoll, sich in weniger relevanten Fällen (low involvement) gewisser Heuristiken zu bedienen. Eine periphere Verarbeitung bedarf, anders als eine zentrale, keines großen Vorwissens, keiner großer Anstrengung und Motivation. Da die eventuell daraus entstehende Meinungsänderung allerdings nicht auf wirklicher Auseinandersetzung mit den Inhalten basiert, ist sie aber auch gegenüber späteren Beeinflussungen wenig resistent. Meinungsänderungen in Folge elaborierter Auseinandersetzung mit dem Thema kommen nur deutlich langsamer und schwerer zu Stande, sind aber in das persönliche Geflecht aus Einstellungen, Normen und Werten integriert und weisen daher eine hohe Widerstandskraft auf und sind dauerhaft.

Zentrale Route: objektiv oder voreingenommen?

Wenn man von der zentralen Route spricht und dabei von elaborierter Auseinandersetzung mit dem Thema die Rede ist, meint man dabei meistens implizit, dass dies auch objektiv geschieht. Das muss allerdings nicht zwingend so sein. Das ELM lässt durchaus auch eine voreingenommene Informationsverarbeitung („biased processing“) zu (Lien, 2000, S. 301-302). In diesem Fall geht man sehr stark subjektiv an die Argumentation heran – wohl gesonnene Argumente werden als wichtiger empfunden, Gegenargumente abgeschwächt oder umgedeutet.

Voreingenomme Informationsverarbeitung tritt meist dann auf, wenn die betreffende Person zum diskutierten Thema bereits vor dem Kontakt mit der persuasiven Botschaft intensiv einen bestimmten Standpunkt einnimmt und nicht gewillt ist, diesen aufzugeben.

Auch wenn man über die persuasive Absicht des Kommunikators gewarnt wurde und ggf. seine Argumente bereits kennt, neigt man dazu, die Sache weniger objektiv anzugehen. Insbesondere neigt man zur Gegenargumentation, wenn man sich vom Kommunikator in eine bestimmte Richtung gedrängt fühlt, dieser einem scheinbar gar keine Wahl lassen will, ob man seinen Standpunkt einnimmt oder nicht.

Letztlich kann es besonders bei Reden auch zur voreingenommen Informationsverarbeitung kommen, wenn kritische Kommentare aus dem Publikum kommen, auf die der Redner nicht souverän reagiert.

Auch wenn bei dieser Herangehensweise der Versuch, die eigentliche Aussage der Botschaft zu erfassen stark in den Hintergrund gedrängt wird, handelt es sich doch um die zentrale Route. Diese behauptet ja nicht, dass man durch die elaborierte Auseinandersetzung mit der Botschaft automatisch auch zu dem richtigen Ergebnis kommt (das „richtige“ Ergebnis würde wegen unterschiedlicher persönlicher Gewichtung der Argumente ohnehin von Person zu Person anders aussehen). Entscheidend ist, dass man sich mit den Argumenten auseinandersetzt (Frey, Stahlberg, 1993, S. 327-260).

Voraussetzungen zum Elaborieren

Damit man sich auf der zentralen Route mit einem Thema beschäftigt, muss zum einen die Motivation dafür vorhanden sein, zum anderen aber auch die persönliche Fähigkeit dazu.

Die Motivation zur Elaboration wird maßgeblich vom Involvement bestimmt, insbesondere also der Eindruck der persönlichen Relevanz des Themas. Dieser Eindruck kann durch äußere Reize verstärkt werden. Beispielsweise kann er bereits dadurch erhöht werden, dass in die zweite Person („Du“) gewechselt wird, der Rezipient also direkt angesprochen wird. In der Werbung wird versucht, die Auseinandersetzung mit den Werbebotschaften dadurch zu fördern, dass Bezüge zum Rezipienten hergestellt werden1. Außerdem steigt die Motivation, sich mit einem Thema auseinander zu setzen, wenn die Anzahl der Quellen, die selbiges thematisieren, hoch ist (Littlejohn, 2002). Auch haben Menschen einen unterschiedlich hohen Bedarf nach Kognitionen (Eckert, 1997, S. 606) – dies wirkt sich natürlich unmittelbar auf die Motivation aus. Die Motivation, sich elaboriert ein Urteil über etwas zu bilden, sinkt, wenn man selbst davon betroffen ist – z.B. wenn es ein Urteil über eine Gruppe zu bilden gilt, der man selbst angehört.

Neben der Motivation müssen natürlich auch die persönlichen kognitiven Fähigkeiten dazu vorhanden sein, um sich elaboriert mit einem Thema befassen zu können. Besonders wichtig ist das Vorwissen, das die jeweilige Person zum Thema mitbringt und auf das er auch aktiv zugreifen kann. Littlejohn veranschaulicht das sehr schön (Littlejohn, 2002, S. 133): „Most students would be more critical of a speech on fashion trends than one on quarks and electrons“ (etwa: „Die meisten Schüler werden einen Vortrag über Modetrends kritischer beurteilen als einen über Quarks und Elektronen.“)

Es gibt noch weitere Faktoren, die die Wahrscheinlichkeit des Elaborierens beeinflussen, die sich grob in Nachrichten- und Rezipientenfaktoren unterteilen lassen.

Auf der Seite der Botschaft können Wiederholungen der Kernaussagen und damit verbunden ein angemessenes Tempo der Informationsaufnahme das Verstehen begünstigen. Insbesondere bei komplexen Themen und einer weniger informierten Zielgruppe ist es wichtig, Argumente zu wiederholen und das Tempo nicht zu hoch zu wählen. Das ist ein Balanceakt: bei zu häufiger Wiederholung oder zu langsamen Tempo entstehen „Ware-Out“-Effekte, Langeweile. Wird ein Argument zu oft gebracht, kann sich der Rezipient gar gedrängt fühlen – voreingenommene Elaboration bzw. verstärkte Gegenargumentation sind das Ergebnis. Ebenso verhält es sich mit der Frage, ob man Schlussfolgerungen explizit ziehen sollte – ist davon auszugehen, dass der Rezipient in der Lage ist, dies selbst zu tun, ist es effektiver, ihn das auch zu lassen; wenn nicht, sollten Schlussfolgerungen explizit gezogen werden.

Auch die Art des Mediums, in dem die Botschaft vorzufinden ist, können die Wahrscheinlichkeit des Elaborierens erhöhen oder senken. Generell fördern Zeitungen bzw. Zeitschriften die elaborierte Informationsverarbeitung, das Fernsehen dagegen ist ein nahezu ausschließlich peripheres Medium. Das Internet gehört zu den eher kognitiven Medien, das Radio liegt irgendwo in der Mitte, aber mit Tendenz richtung peripher. Dies wird durch den bereits erwähnten Geschwindigkeits-Faktor verstärkt: Bei Print- und Onlinemedien kann sich jeder Rezipient das Tempo der Informationsaufnahme selbst vorgeben, wohingegen man sich bei TV und Radio nach den Vorgaben des Mediums richten muss (Schenk, 2002, S. 260).

Hohe Glaubwürdigkeit der Quelle und Expertenmeinungen können bei mittelhohem Involvement zum Elaborieren anregen (Schenk, 2002, S. 260-261).

Auf der Seite des Rezipienten sind es in erster Linie Faktoren, die die momentane Befindlichkeit des Rezipienten betreffen. Besondere Beachtung gilt dabei Untersuchungen, inwieweit die Wahrscheinlichkeit des Elaborierens von der Stimmung abhängt. Allgemein wird davon ausgegangen, dass eine gute Stimmung eine elaborierte Auseinandersetzung mit dem Thema eher behindert (Batra, Stayman, 1990). Unter manchen Umständen kann sie aber wiederum förderlich sein, z.B. wenn der Rezipient davon ausgehen kann, dass die gute Stimmung dadurch nicht beeinträchtigt wird (Wegener et al, 1995). Gerade dieser Punkt scheint noch genauerer Forschung und Systematisierung zu bedürfen.

Befindet man sich in einem Stadium starker Erregung, neigt man zu peripherer Informationsverarbeitung, eine elaborierte Auseinandersetzung wird also eher behindert (Lien, 2000, S. 303). Dass es die elaborierten Informationsverarbeitung außerdem behindert, wenn man von der „Außenwelt“ abgelenkt wird, dürfte klar sein.

Daneben hat auch die Körperhaltung einen Einfluss auf die Wahrscheinlichkeit des Elaborierens: Liegt oder sitzt man bequem, fällt es einem leichter, sich intensiv mit einem Thema zu beschäftigen, als wenn man steht oder geht (Petty, 1983, S. 209-222).

Die Persuasion

Das Elaboration Likelihood Modell besagt nicht nur, dass es zwei Routen in der Informationsverarbeitung gibt und welche Route wann eingeschlagen wird, sondern trifft auch Aussagen darüber, wie die Persuasionskraft von Botschaften davon beeinflusst wird, welche Route eingeschlagen wird.

Verschiedenste Faktoren haben einen Einfluss darauf, wie überzeugend eine Botschaft auf einen Rezipienten wirkt. Eine Betrachtung, die eine möglichst vollständige Liste dieser Faktoren anstrebt, würde diesen Rahmen natürlich sprengen. Interessant in Hinblick auf das ELM sind inbesondere jene Faktoren, die sich bei zentraler und peripherer Verarbeitung unterschiedlich auswirken.

Der komplette Bereich der äußeren Reize spielt wie bereits erwähnt nahezu exklusiv in der peripheren Route eine Rolle. Dazu gehören Punkte wie schöne Bilder, Musik, Kameraperspektive und dergleichen mehr (Lien, 2000, S. 304-304).

Auch „Aufwärtsvergleiche“ werden zu den peripheren Reizen gezählt. Von Aufwätsvergleichen ist z.B. die Rede, wenn die Tatsache, dass eine bereits bekannte Person einen bestimmten Standpunkt einnimmt bzw. ein Produkt verwendet, als Argument für diesen Standpunkt bzw. dieses Produkt verwendet wird (Schenk, 2002, S. 261). Dies muss sich natürlich nicht nur auf Personen beziehen.

Die Anzahl der Argumente kann unterschiedliche Auswirkungen auf die Persuasionskraft haben. Wird die Botschaft rein peripher ausgewertet, zählt die reine Anzahl als Reiz. Da keine genauere Auseinandersetzung mit den einzelnen Argumenten erfolgt, spielt es folglich auch keine Rolle, ob es sich dabei um starke oder schwache Argumente handelt – die reine Masse zählt. Wird die Botschaft dagegen elaboriert verarbeitet, kann es dagegen sogar kontraproduktiv sein, wenn um jeden Preis möglichst viele Argumente unabhängig von deren Qualität untergebracht werden – hat man starke Argumente, sollte sich die Botschaft auf diese konzentrieren, die Überzeugungskraft sinkt eher, wenn diese mit schwachen Argumenten „verwässert“ werden (Schenk, 2002, S. 261).

Der selbe Sachverhalt hat natürlich auch eine Wirkung auf die Überzeugungskraft der einzelnen Argumente an sich: während auf der peripheren Route praktisch jedes Argument etwa gleich viel, mäßig viel, zur Überzeugung beiträgt, haben bei der zentralen Route starke Argumente naturgemäß mehr Wirkung als schwache. Botschaften mit eher schwachen Argumenten wirken in der zentralen Route also eher weniger überzeugend, während bei Botschaften mit viel starken Argumenten bei Verarbeitung in der zentralen Route sogar eine höhere Persuasionsrate entstehen kann als bei peripherer Verarbeitung (die anfängliche Aussage, Meinungsänderungen durch die zentrale Route kämen nur viel langsamer und schwerer zu Stande, ist dahingehend zu relativieren) (Schenk, 2002, S. 257-258).

Verfasst man eine persuasive Botschaft, ist auch bei der Entscheidung, ob die Argumentation einseitig gehalten werden oder Pro- und Kontraargumente berücksichtigen soll, zu beachten, ob eher die periphere oder die zentrale Route angesprochen werden soll. Bei elaborierter Verarbeitung erhöht zweiseitige Argumentation die Glaubwürdigkeit der Botschaft, wirkt sich also positiv auf die Überzeugungskraft der Botschaft aus. Bei peripherer Verarbeitung kann die Einbeziehung von Gegenargumenten der Gesamtwirkung eher abträglich sein. Dieser Punkt zeigt sehr schön, wie auch frühere Ergebnisse der Persuasionsforschung mit dem ELM interpretieren lassen: ähnliche Befunde gab es bereits in den Yale Studies (Hovland et al., 1949).

Quellenfaktoren, insbesondere die Glaubwürdigkeit der Quelle sind hauptsächlich periphere Reize. Ist die Quelle glaubwürdig, steigt bei peripherer Verarbeitung die Überzeugungskraft der Botschaft, bei elaborierter Verarbeitung bleibt sie dagegen nahezu unverändert (Schenk, 2002, S. 260-261).

Die Stimmung, in der sich der Rezipient gerade befindet, hat ebenfalls einen nicht unwesentlichen Einfluss darauf, wie eine Botschaft auf ihn wirkt. In der peripheren Route ist die Stimmung ein äußerer Reiz – positive Stimmung wirkt sich unmittelbar in eine positivere Einstellung dem Thema bzw. dem Produkt gegenüber aus. Aber auch bei elaborierter Auseinandersetzung kann sich eine positive Stimmung auswirken: (unabhängig von der bereits erwähnten Tatsache, dass eine sehr positive Stimmung das Elaborieren eher unwahrscheinlicher macht) die Stimmung beeinflusst die Gedanken, die man sich zum Thema macht, so dass man in diesem Fall eher zu positiven Gedanken neigt und damit auch das Gesamturteil etwas positiver ausfallen dürfte – die Stimmung wirkt dann also nur indirekt auf die Überzeugungskraft.

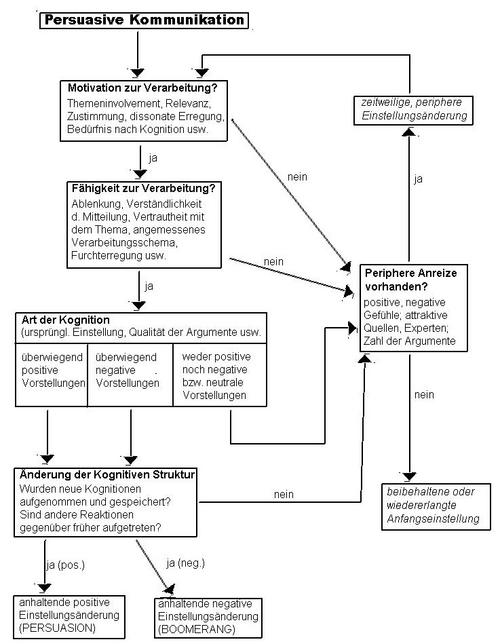

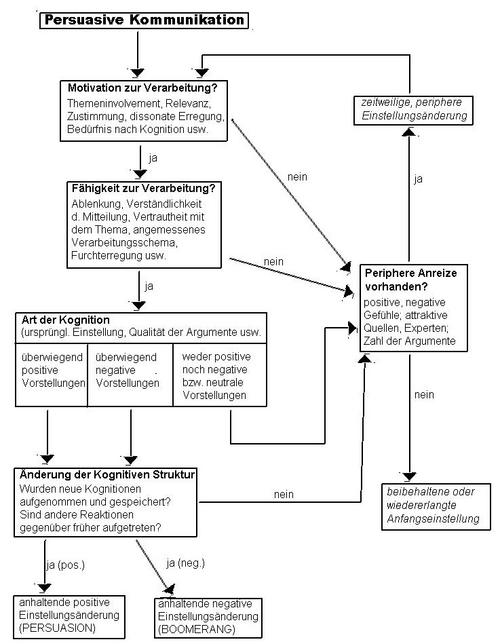

Das ELM – visualisiert

Elaboration Likelihood-Modell nach PETTY, R.E., J.T. CACIOPPO, 1986, S.4

Grafik aus Schenk, M. (2002). Medienwirkungsforschung (S. 255). Tübingen: J.C.B. Mohr

Kleine Änderungen zur Vermeidung von Missverständnissen vorgenommen

(Verschiebung eines falsch gesetzten Pfeils)

Das dargestellte Modell soll die Grundkonzepte des ELM nocheinmal visualisieren. Die linke Spalte stellt die zentrale Route dar, die rechte die periphere. Das Flussdiagramm macht deutlich, dass zu einer elaborierten Auseinandersetzung sowohl die Motivation, als auch die Fähigkeit zur Verarbeitung vorhanden sein muss. Nur wenn beides vorhanden ist, die Botschaft entweder überwiegend positive oder negative Kognitionen hervorruft und diese letztlich auch in die persönliche kognitive Struktur integriert wird, kann eine dauerhafte Einstellungsänderung erfolgen. Ansonsten ist bestenfalls eine kurzfristige Meinungsänderung auf der peripheren Route möglich. Diese jeweilige Meinungsänderung muss natürlich nicht unbedingt im Sinne der persuasiven Botschaft sein – auch der Boomerang-Effekt, das Einnehmen einer der Botschaft entgegengesetzten Haltung, ist möglich.

Fazit

Nach über 20 Jahren zählt das Elaboration Likelihood Modell nach wie vor zu den verbreitetsten seiner Art. Das Grundkonzept des ELM, die Unterscheidung zwischen elaborierter und peripherer Informationsverarbeitung, hat allgemeine Anerkennung gefunden. Noch nicht geklärt ist allerdings, ob diese beiden Routen tatsächlich so unabhängig voneinander existieren, wie dies im ELM beschrieben wird (die Verfasser relativierten diese strikte Trennung ohnehin recht schnell wieder). Wahrscheinlicher ist, dass beide Routen in gewissem Sinne gleichzeitig eingeschlagen werden, oder sich zumindest regelmäßig abwechseln, wie dies z.B. im Modell der Heuristisch-Systematischen Informationsverarbeitung der Fall ist. Wie dies genau erfolgt, wird sicherlich noch Stoff zukünftiger Forschungen sein.

Interessant ist, dass das ELM weniger versucht, das Ergebnis persuasiver Kommunikation zu beschreiben, sondern vielmehr den Prozess, der dazu führt. Diese prozessorientierte Herangehensweise deckt sich auch mit vielen anderen Forschungen der aktuellen Werbeforschung.

Das ELM wurde viel verwendet, um Effekte der Werbung und des Marketings zu erklären und hat darin gute Dienste geleistet: es stellt eine gute Basis für Betrachtungen dar, ist im Kern einfach zu verstehen und auch erweiterbar. Neben der Werbung ist es auch für viele andere Bereiche der Kommunikationsforschung anwendbar.

Als Beispiel dafür, wie das ELM heutzutage angewendet wird, sei die Studie „eELM: A Replication and Refinement of the Elaboration Likelihood Model for Computer mediated environments“ (Hershberger, 2002), die zu den jüngsten Anwendungen des ELMs gehört. Untersucht wird die Werbewirkung im Internet. Das ELM wird um mehrere Faktoren erweitert, insbesondere um „Erfahrung mit dem Netz“ („web experts“ zeigen sich resistenter gegenüber peripheren Reizen bei Bannerwerbung), und „Vertrauen ins Netz“ (differenziert in Vertrauen in andere Benutzer, in Organisationen und in die Technik) und der Einfluss verschiedener Eigenschaften von Bannerwerbung auf den Persuasionsprozess untersucht (neben Attributen wie Farbe, Animation und Informationsgehalt auch Kontexteigenschaften wie die Einstellung des Rezipienten zur Website, auf der das Banner platziert ist). Dieses Beispiel soll verdeutlichen, wie das ELM ohne Probleme erweitert und spezialisiert werden kann, um weitere Formen der Werbewirkung zu untersuchen.

In vielen Bereichen sind aber noch weitere Forschungen notwendig. Als Beispiel sei nur der Einfluss der Stimmung auf den Persuasionsprozess genannt. Auch die Abhängigkeiten der einzelnen Faktoren untereinander sind noch nicht völlig erkundet.

Literaturverzeichnis

- Batra, R., & Stayman, D. M. (1990). The role of mood in advertising effectiveness. Journal of Consumer Research, 17, 203-214.

- Cacioppo J. & Petty R. (1986). Communication and persuasion. New York: Springer Verlag.

- Cacioppo J. & Petty R. (1981). Attitudes and Persuasion: Classic and contemporary approaches. Dubuque, Iowa: Brows.

- Donnerstag, J. (1996). Der engagierte Mediennutzer: Das Involvement-Konzept in der Massenkommunikationsforschung. München: R.Fischer.

- Eckert, J.A. & Goldsby, T.J. (1997). Using the Elaboration Likelihood Model to Guide Customer Service-Based Segmentation. International Journal of Physical Distribution and Logistics Management, 27, 600-615

- FOCUS-Lexikon für Mediaplanung Markt- und Mediaforschung, [Online]. Erhältlich: http://medialine.focus.de [1. Oktober 2003]

- Frey, D., Stahlberg, D. (1993). Das Elaboration-Likelihood-Modell von Petty und Cacioppo. In Frey, D., Irle. M. (Hrsg.), Theorien der Sozialpsychologie Bd. I: Kognitive Theorien. Bern: Verlag Hans Huber

- Hersherger, E.K. (2002). eELM: A Replication and Refinement of the Elaboration Likelihood Model for Computer Mediated Environments, [Online]. Erhältlich: http://ehershberger.tripod.com/papers/ hershbergerproposal.pdf [1. Oktober 2003].

- Hovland, C. & Lumsdaine, A., & Sheffield, F. (1949). Experiments on Mass Communication. New Haven: Yale University Press

- Lien, N. H. (2001). Elaboration Likelihood Model in Consumer Research: A Review, [Online]. Erhältlich: http://nr.stic.gov.tw/ejournal/ProceedingC/ v11n4/301-310.pdf [1. Oktober 2003]

- Littlejohn, S.W. (2002). Theories of human communication. Stamford: Wadsworth Publishing.

- Krishnamurthy, P., & Sujan, M. (1999). Retrospection versus anticipation: The role of ad under retrospective and anticipatory self-referencing. Journal of Consumer Research, 26, 55-69

- Kunczik, M. & Zipfel, A. (2001). Publizistik. Köln: Böhlau.

- Nebergall, R.E. & Sherif, C.W. & Sherif, M. (1965). Attitude and attitude change. Philadelphia: W. B. Sunders Company

- Petty, R. E. & Wells, G. L. & Heesacker, M. & Brock, T. C., & Cacioppo, J. T. (1983). The effects of recipient posture on persuasion: A cognitive response analysis Personality and Social Psychology Bulletin, 9, 209-222

- Richardson, E. (2002). Elaboration Likelihood Model, [Online]. Erhältlich: http://eworld.ericrichardson.com/verbal/elm [1. Oktober 2003]

- Schenk, M. (2002). Medienwirkungsforschung. Tübingen: J.C.B. Mohr

- Sherif, C.W. & Sherif, M. (1967). Attitude, Ego-Involvement, and Change. New York: John Wiley & Sons

- Wegener, D. T. & Petty, R. E., & Smith, S. M. (1995). Positive mood can increase or decrease message scrutiny: The hedonic contingency view of mood and message processing. Journal of Personality and Social Psychology, 69, 5-15.